模型提供商

OpenAI 兼容自定义提供商

在陪读蛙中配置任何兼容 OpenAI API 的提供商,包括第三方服务和自托管解决方案

302.AI 特别优惠

开始使用 302.AI,获取最新模型的按用量付费服务。通过我们的链接注册可获得 1 美元免费额度。

什么是 OpenAI 兼容提供商?

OpenAI 兼容提供商是实现与 OpenAI 相同 API 接口的服务,使它们成为即插即用的替代品。这种标准化允许您:

- 连接到代理服务 提供对多种模型的访问

- 访问区域 AI 服务 提供 OpenAI 兼容端点

- 使用自托管解决方案 完全控制您的数据

- 连接企业 AI 服务 遵循 OpenAI API 标准

兼容提供商选项

陪读蛙包含几个预配置的 OpenAI 兼容提供商以便使用:

SiliconFlow

- 基础 URL:

https://api.siliconflow.cn/v1 - 模型: Qwen/Qwen3-Next-80B-A3B-Instruct

- 适用于: 中国和国际模型的高性能推理

Tensdaq

- 基础 URL:

https://tensdaq-api.x-aio.com/v1 - 模型: DeepSeek v3.1、Qwen3-235B-A22B-Instruct-2507

- 适用于: 革命性竞价平台,市场驱动定价

302.AI

- 基础 URL:

https://api.302.ai/v1 - 模型: GPT-4.1 Mini、Qwen3-235B-A22B

- 适用于: 中国最新模型,按用量付费 API

和一个完全自定义的提供商选项,您可以配置任何 OpenAI 兼容服务。

Custom Provider

- 基础 URL: 可配置(例如:

https://api.example.com/v1) - 模型: 使用自定义模型名称

- 适用于: 任何 OpenAI 兼容服务

详细配置指南

第一步:访问设置页面

- 点击浏览器工具栏中的陪读蛙扩展图标

- 在弹出窗口中点击「选项」按钮

- 或者右键点击扩展图标,选择「选项」

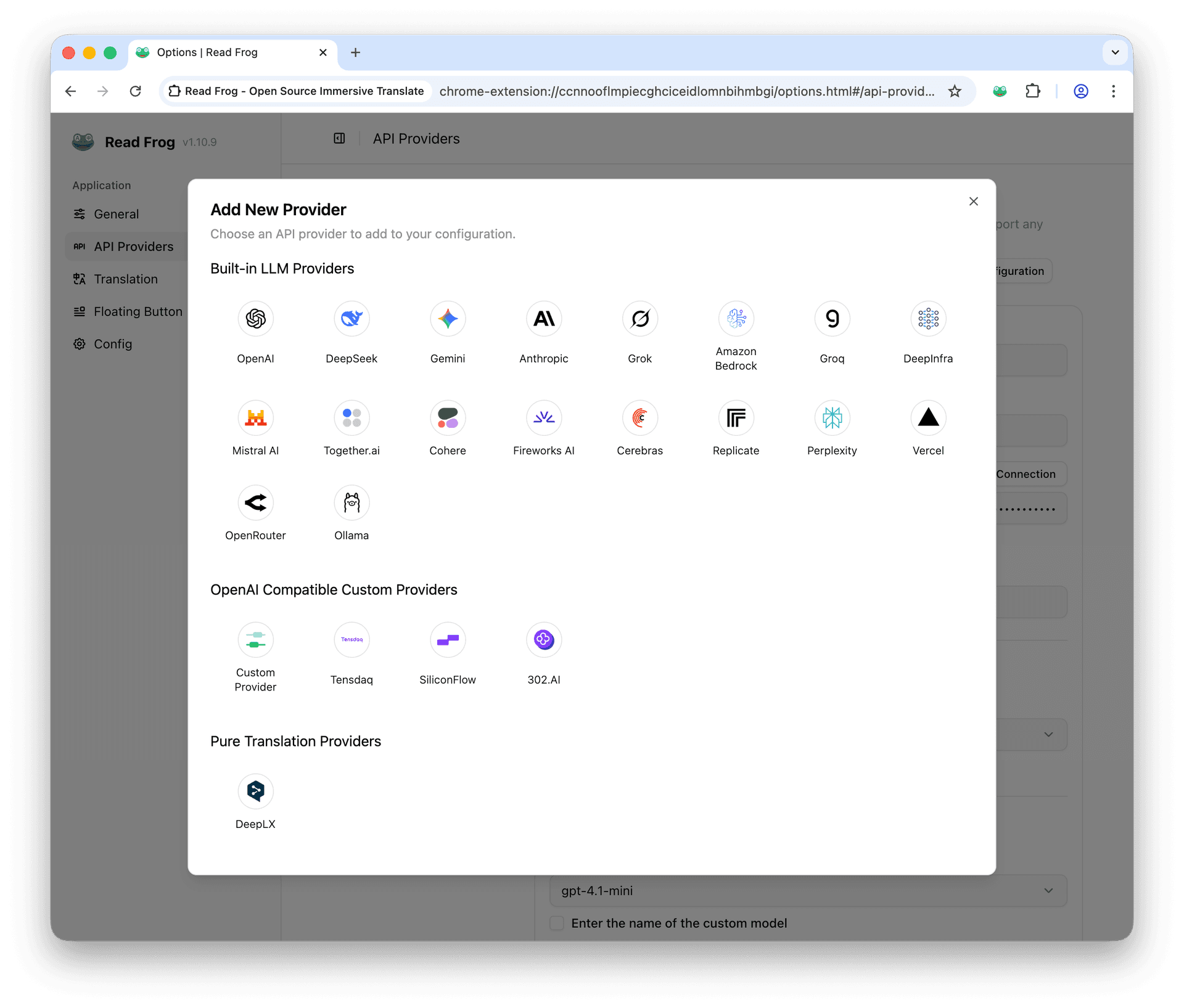

第二步:选择提供商

点击「添加提供商」按钮,选择「内置 LLM 提供商」部分,选择您想要使用的提供商。

第三步:获取 API 密钥

在对应的地方添加 API Key。如果您是自托管的服务,您可以去后台创建 API Key。如果您是第三方服务,您可以去对应的服务商官网创建 API Key。

第四步:配置模型选择

我们有两种场景:翻译和阅读。我们推荐您根据使用场景选择合适的模型。

| 场景 | 说明 | 要求 |

|---|---|---|

| 翻译 | 仅用于将文字从一种语言翻译成另一种语言 | 推荐使用速度较快的小模型 |

| 阅读 | 阅读文章,并进行分析和总结 | 需要支持结构化输出的模型 |

陪读蛙的阅读功能需要 AI 模型能够输出特定格式的 JSON 对象。并非所有模型都支持此功能

- ✅ 完全支持:OpenAI GPT 系列、Google Gemini 系列、Anthropic Claude 系列

- ⚠️ 部分支持:DeepSeek、大部分开源模型(可能需要调整)

- ❌ 不支持:较老的模型或不支持 JSON 输出的模型

第五步:验证配置

配置完成后进行测试:

- 点击「测试连接」按钮

- 系统发送测试请求

- 查看返回结果确认配置正确

- 如果失败,检查 API 密钥和网络连接

故障排除指南

常见配置问题

| 问题类型 | 症状 | 解决方案 | 验证方法 |

|---|---|---|---|

| API 密钥错误 | "Invalid API Key" | 重新复制密钥,检查空格 | 测试连接按钮 |

| 余额不足 | "Quota exceeded" | 充值账户或更换提供商 | 查看提供商控制台 |

| 网络问题 | 连接超时 | 检查网络,尝试代理 | ping 提供商域名 |

| 模型限制 | 模型不可用 | 检查权限,选择其他模型 | 查看提供商文档 |

总结

通过本指南,您应该能够:

- ✅ 了解各提供商的特点和适用场景

- ✅ 成功配置所需的 AI 提供商

- ✅ 选择适合的模型进行翻译和阅读

- ✅ 解决常见的配置和使用问题

如果您在使用过程中遇到其他问题,建议查看提供商的官方文档或在陪读蛙 Discord 社区寻求帮助。